HunyuanVideo 1.5: O Modelo de Vídeo Leve e Open-Source da Tencent

A equipe Hunyuan AI da Tencent lançou oficialmente o HunyuanVideo 1.5, um modelo de geração de vídeo poderoso, porém leve e open-source. Diferente de muitos modelos de vídeo avançados que exigem GPUs de altíssimo desempenho, esta versão foi otimizada para rodar em hardwares mais acessíveis, oferecendo geração de movimento de alta qualidade, múltiplos estilos e suporte tanto para texto-para-vídeo quanto imagem-para-vídeo. Para desenvolvedores, criadores e pesquisadores de IA, o HunyuanVideo 1.5 representa um passo significativo na democratização da geração de vídeos. Neste artigo, exploraremos profundamente sua arquitetura, desempenho, casos de uso e limitações práticas — para que você compreenda exatamente o que torna este modelo único.

Parte 1: O Que É o HunyuanVideo 1.5?

HunyuanVideo é a série de modelos de base da Tencent projetada para geração de vídeos. A versão 1.5 é a última iteração pública, open-source, liberada pela equipe Hunyuan da Tencent. De acordo com relatórios oficiais, o HunyuanVideo 1.5 possui 8,3 bilhões de parâmetros e utiliza uma arquitetura Diffusion-Transformer (DiT). Este modelo suporta tanto texto-para-vídeo (T2V) quanto imagem-para-vídeo (I2V), tornando-o extremamente flexível para criadores.

Principais Melhorias na Versão 1.5

Fonte: Tencent Hunyuan

- Leve, mas de alto desempenho: Com apenas 8,3 bilhões de parâmetros, é muito menor que muitos modelos open-source de referência, mas ainda entrega excelente qualidade de vídeo.

- Baixa exigência de hardware: A Tencent afirma que o modelo roda suavemente em GPUs de consumidor (~14 GB de VRAM).

- Coerência avançada de movimento: Graças ao novo mecanismo de atenção esparsa chamado Selective and Sliding Tile Attention (SSTA), o modelo equilibra fidelidade do movimento com eficiência na inferência.

- Compreensão multimodal: Suporta prompts bilíngues (chinês/inglês) e pode seguir instruções detalhadas, como movimentos de câmera, movimentos humanos realistas, expressões emocionais e transições de cena.

- Múltiplos estilos visuais: Permite gerar cenas realistas, animadas ou em estilo "bloco/bricks", e até sobrepor textos diretamente no vídeo.

- Duração e resolução de vídeo: Suporta nativamente clipes de 5-10 segundos em 480p e 720p, e com um modelo de super-resolução, é possível aumentar para 1080p.

Fluxos de Trabalho Suportados pelo HunyuanVideo 1.5

O HunyuanVideo 1.5 é flexível e suporta múltiplos modos de geração:

- Texto-para-Vídeo (T2V): Gerar clipes curtos diretamente a partir de prompts

- Imagem-para-Vídeo (I2V): Animar imagens estáticas com instruções de movimento

- Estilização e geração criativa: Anime, cinematográfico, surreal, estilo bloco e mais

- Ajustes finos e extensões LoRA: Permite treinar para estilos específicos, personagens ou tarefas criativas

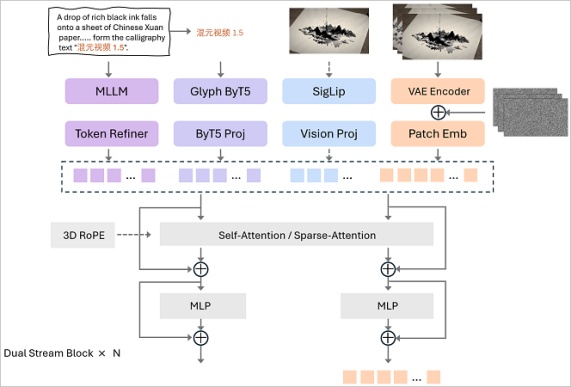

Parte 2: Como Funciona o HunyuanVideo 1.5

O HunyuanVideo 1.5 é baseado em uma arquitetura híbrida Diffusion Transformer (DiT). Seus componentes principais incluem: backbone de transformer, atenção esparsa seletiva (SSTA) para reduzir o cálculo e um espaço latente unificado que suporta geração de imagens e vídeos. A equipe também introduziu codificação de texto consciente de glifos, melhorando a compreensão de caracteres chineses e texto em inglês.

Um dos destaques do HunyuanVideo 1.5 é a capacidade de produzir movimento suave e coerente ao longo do tempo. O mecanismo SSTA permite atenção eficiente entre os quadros, ajudando o modelo a manter estrutura consistente, iluminação realista e plausibilidade física nas sequências geradas. Isso é combinado com uma estratégia de treinamento progressivo que reforça gradualmente a coerência do movimento.

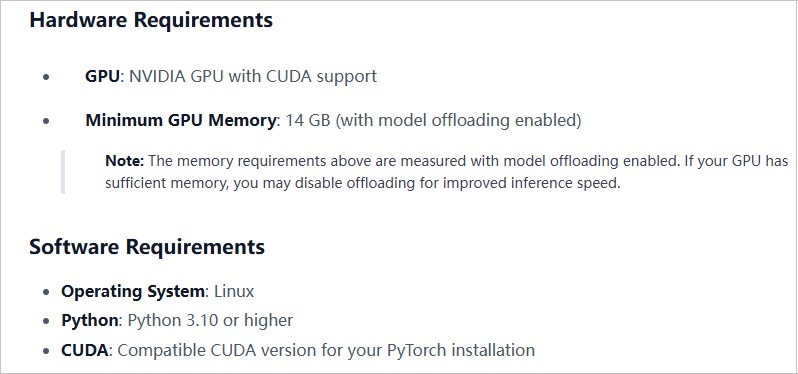

Requisitos de Hardware e Eficiência na Inferência

Fonte: Tencent Hunyuan

De acordo com a Tencent, o modelo é voltado para GPUs de nível consumidor, com cerca de 14 GB de VRAM. Usuários do Reddit relatam que, com quantização ou caching, a inferência se torna mais eficiente. O lançamento open-source também suporta formatos de quantização leve, tornando-o mais acessível para máquinas de menor especificação.

Parte 3: Desempenho Real e Comparações

Em testes práticos e relatos de usuários, o HunyuanVideo 1.5 consegue gerar clipes de 5-10 segundos visualmente coerentes, com movimento fluido, expressões humanas realistas e instruções de direção, como panorâmica de câmera ou zoom.

Suporta diferentes estilos artísticos — realista, animado, em blocos — e pode até sobrepor texto diretamente nos frames do vídeo.

A extensão de super-resolução do modelo permite aos usuários aumentar a resolução nativa de 480p/720p para 1080p.

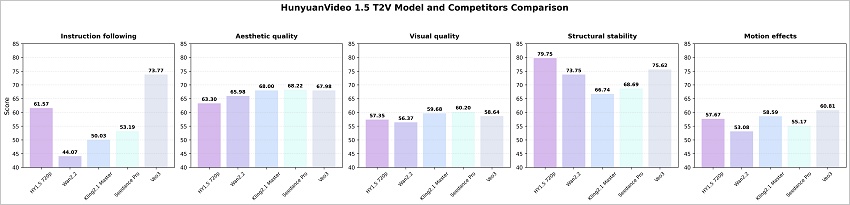

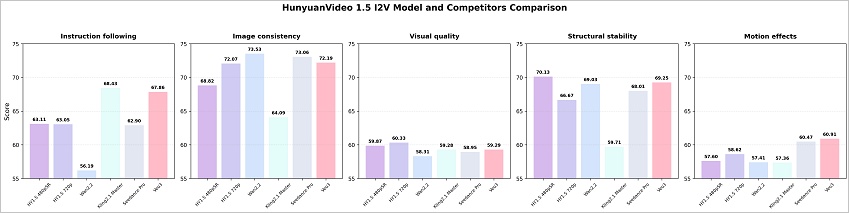

HunyuanVideo 1.5 vs Modelos Proprietários / Fechados

Comparado a sistemas de geração de vídeo fechados e de grande porte, o HunyuanVideo 1.5 oferece um equilíbrio atraente entre qualidade e acessibilidade. Enquanto alguns modelos corporativos exigem dezenas de bilhões de parâmetros e hardware de ponta, o HunyuanVideo 1.5 reduz significativamente a barreira, suportando hardware mais acessível sem sacrificar muito a fidelidade visual.

Essa democratização torna o modelo muito mais utilizável para criadores individuais, startups ou pesquisadores acadêmicos que não possuem infraestrutura de computação massiva.

Fonte: Tencent Hunyuan

HunyuanVideo vs Outras Alternativas Open-Source

No espaço de modelos de vídeo open-source, o HunyuanVideo 1.5 compete com ferramentas como CogVideoX, AnimateDiff ou modelos de vídeo estilo Mochi. Suas principais vantagens são:

- Menor quantidade de parâmetros (inferência mais rápida)

- Compreensão bilíngue de prompts

- Mecanismo de atenção eficiente para dinâmica temporal consistente

- Equilíbrio entre resolução de vídeo e velocidade de geração

No entanto, alguns modelos open-source especializados podem superar o Hunyuan em nichos como vídeos de longa duração, cenas 3D ou conteúdos de fantasia altamente estilizados.

Parte 4: Como Usar o HunyuanVideo 1.5

Fluxo Texto-para-Vídeo (T2V)

- 1. Prepare seu prompt:Escreva uma cena descritiva e concisa (ex.: "um rio calmo ao pôr do sol, um pequeno barco flutuando, luz dourada") em inglês ou chinês.

- 2. Carregue o modelo:Use uma interface ou ferramenta compatível (como ComfyUI) para carregar o HunyuanVideo 1.5 (garanta que está usando uma versão quantizada ou em cache se sua GPU for limitada).

- 3. Configure os parâmetros de geração:Escolha a duração (ex.: 5-10 segundos), resolução (480p ou 720p) e número de frames.

- 4. Execute a inferência:Gere o vídeo. Com caching ou inferência otimizada, o processo pode ser significativamente mais rápido.

- 5. Pós-processamento opcional:Use um modelo de super-resolução para aumentar para 1080p se necessário, ou aplique color grading externamente.

Fluxo Imagem-para-Vídeo (I2V)

- 1. Faça upload ou forneça uma imagem:Use uma foto estática ou obra de arte que deseja animar.

- 2. Adicione um prompt:Descreva como a cena deve se mover (ex.: "os galhos da árvore balançam suavemente, a luz do sol cintila").

- 3. Configure o modo do modelo:Selecione opções de inferência adequadas para I2V (ex.: configurações DiT, SSTA).

- 4. Gere o vídeo:Execute o modelo para produzir um clipe animado curto. Muitos usuários conseguem criar movimento natural a partir de imagens estáticas.

- 5. Revise e ajuste:Ajuste o prompt ou configurações se necessário para melhorar a consistência e fidelidade do movimento.

Uso Avançado (Opcional)

- Fine-tuning / LoRA:Tecnicamente possível, embora a maioria dos usuários utilize pesos quantizados ou em cache.

- Pipelines em múltiplas etapas:Combine o HunyuanVideo com outros modelos open-source para upscaling, transferência de estilo ou pós-edição.

- Integração com ComfyUI:Fluxos da comunidade suportam nós do ComfyUI para geração eficiente mesmo em GPUs de médio desempenho.

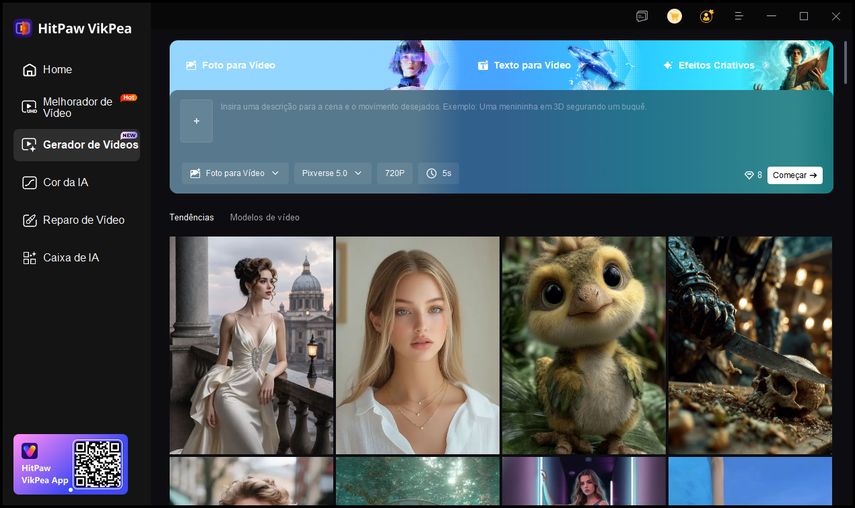

Bônus: Uma Alternativa Prática - HitPaw VikPea

Para quem deseja gerar vídeos TikTok de alta qualidade sem complicações técnicas, o HitPaw VikPea é a escolha ideal. Ele permite criar vídeos em 4K usando IA, tanto a partir de texto quanto de imagens, com uma interface simples e intuitiva.

-

Passo 1.Instale e abra o HitPaw VikPea no Windows ou Mac, e selecione a ferramenta AI Video Generator na interface principal.

-

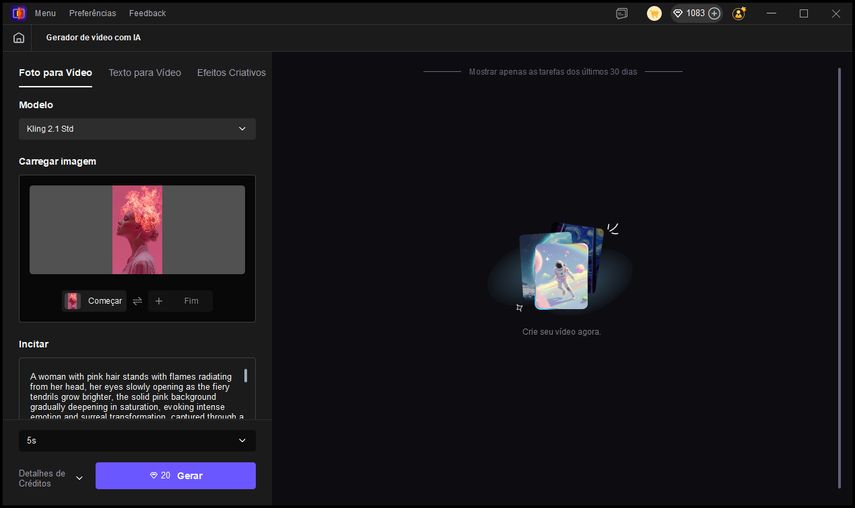

Passo 2.Forneça um prompt ou faça upload de imagens: escolha Text-to-Video para clipes a partir de texto ou Image-to-Video e importe os frames inicial e final.

-

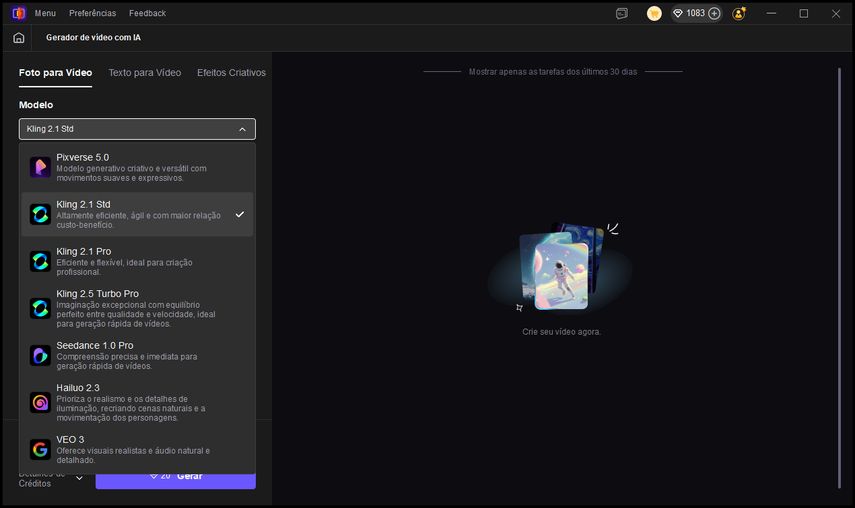

Passo 3.Selecione um modelo de IA, como Kling2.1 ou Kling2.5, e ajuste as configurações de saída: duração do vídeo, resolução e outras opções para controlar o resultado final.

-

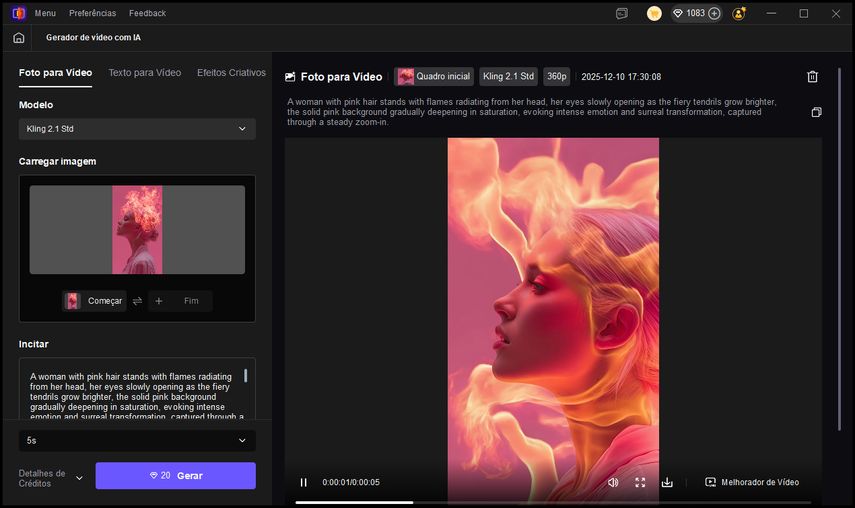

Passo 4.Clique em Generate para iniciar a criação. Pré-visualize o resultado e faça o download usando o controle de salvar ou aprimore ainda mais com a função Video Enhancer.

Experimente o HitPaw VikPea gratuitamente para criar vídeos TikTok em 4K rapidamente e com qualidade profissional, sem necessidade de configurações complexas.

Perguntas Frequentes sobre o Modelo HunyuanVideo 1.5

Q1. O HunyuanVideo 1.5 está disponível publicamente?

A1. Sim. A Tencent tornou o HunyuanVideo 1.5 open-source, e os pesos do modelo e o código de inferência estão disponíveis para a comunidade.

Q2. Qual hardware é necessário para rodar o HunyuanVideo 1.5?

A2. Embora o modelo seja otimizado para hardware mais leve, a Tencent sugere cerca de 14 GB de VRAM para uma inferência fluida. Usuários também relataram conseguir rodar fluxos de trabalho menores em placas com 8 GB+, embora vídeos mais longos ou em maior resolução possam exigir mais recursos.

Q3. Ele realmente faz tanto Text-to-Video quanto Image-to-Video?

A3. Sim. Segundo fontes oficiais, o HunyuanVideo 1.5 suporta gerar vídeos a partir de prompts de texto ou imagens estáticas.

Q4. Qual a duração dos vídeos produzidos por este modelo?

A4. O modelo foi projetado para gerar clipes de vídeo de 5 a 10 segundos, de acordo com o anúncio público da Tencent.

Q5. Qual resolução ele pode gerar?

A5. Por padrão, ele suporta 480p e 720p. Resolução maior (1080p) é possível se você aplicar um modelo de super-resolução separado.

Conclusão

O HunyuanVideo 1.5 demonstra o avanço da geração de vídeo open-source, oferecendo maior consistência de movimento, resolução mais alta e fluxos de trabalho T2V/I2V totalmente unificados. É uma excelente escolha para pesquisadores e criadores que precisam de flexibilidade e controle sobre o modelo. Mas para usuários que desejam resultados rápidos e de alta qualidade sem se preocupar com hardware ou configurações, o HitPaw VikPea oferece uma alternativa prática. Ele permite gerar vídeos profissionais de IA por meio de uma interface intuitiva, tornando a criação avançada de vídeos acessível a todos.

Experimente Agora!Deixe um Comentário

Crie sua avaliação para os artigos do HitPaw